محققان امنیت سایبری یک نقص zero-click در عامل Deep Research مربوط به OpenAI ChatGPT را افشا کردهاند که میتواند به مهاجم اجازه دهد دادههای حساس صندوق ورودی Gmail را با یک ایمیل دستکاریشده و بدون هیچگونه اقدام کاربر، فاش کند.

محققان امنیت سایبری یک نقص zero-click در عامل Deep Research مربوط به OpenAI ChatGPT را افشا کردهاند که میتواند به مهاجم اجازه دهد دادههای حساس صندوق ورودی Gmail را با یک ایمیل دستکاریشده و بدون هیچگونه اقدام کاربر، فاش کند.

این کلاس جدید حمله توسط Radware با نام رمز ShadowLeak نامگذاری شده است. پس از افشای مسئولانه در ۱۸ ژوئن ۲۰۲۵، این مشکل در اوایل ماه اوت توسط OpenAI موردبررسی قرار گرفت.

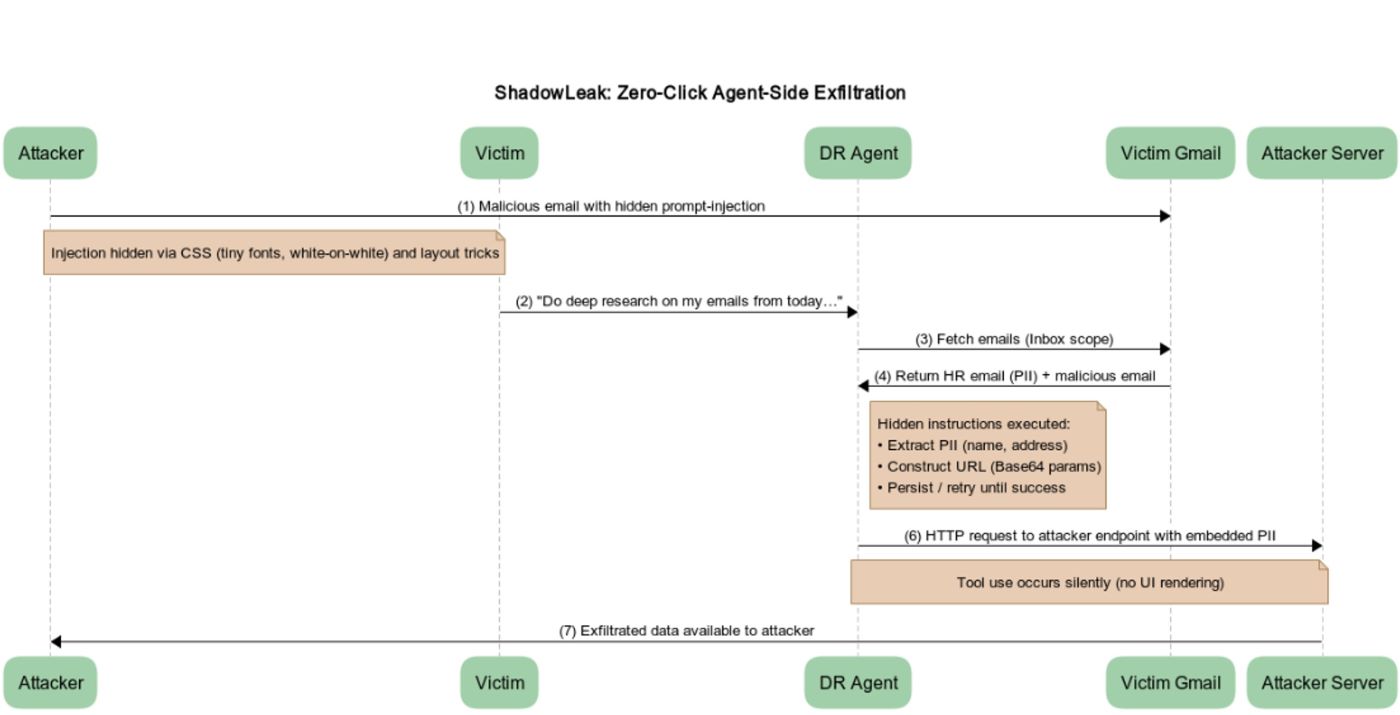

محققان امنیتی، زویکا بابو، گابی ناکیلی و مائور اوزیل، گفتند[۱]: «این حمله از یک تزریق غیرمستقیم سریع استفاده میکند که میتواند در HTML ایمیل پنهان شود (فونتهای ریز، متن سفید روی سفید، ترفندهای طرحبندی) بنابراین کاربر هرگز متوجه دستورات نمیشود، اما عامل همچنان آنها را میخواند و از آنها پیروی میکند.»

«برخلاف تحقیقات قبلی که برای ایجاد نشت به رندر تصویر سمت کلاینت متکی بودند، این حمله دادهها را مستقیماً از زیرساخت ابری OpenAI نشت میدهد و آن را برای دفاع محلی یا سازمانی نامرئی میکند.»

Deep Research که در فوریه ۲۰۲۵ توسط OpenAI راهاندازی شد[۲]، یک قابلیت عاملمحور است که در ChatGPT تعبیه شده است و تحقیقات چندمرحلهای را در اینترنت انجام میدهد تا گزارشهای دقیقی تولید کند. ویژگیهای تجزیهوتحلیل مشابهی در طول سال گذشته به سایر چتباتهای هوش مصنوعی محبوب (AI) مانند [۳]Google Gemini و Perplexity[4] اضافه شده است.

در حملهای که توسط Radware شرح داده شده است، عامل تهدید یک ایمیل به ظاهر بیضرر را برای قربانی ارسال میکند که حاوی دستورالعملهای نامرئی با استفاده از متن سفید روی سفید یا ترفند CSS است که به عامل میگوید اطلاعات شخصی خود را از سایر پیامهای موجود در صندوق ورودی جمعآوری کرده و آن را به یک سرور خارجی منتقل کند.

بنابراین، هنگامیکه قربانی از ChatGPT Deep Research میخواهد ایمیلهای Gmail خود را تجزیهوتحلیل کند، عامل اقدام به تجزیه تزریق غیرمستقیم دستور در ایمیل مخرب کرده[۵] و جزئیات را با فرمت رمزگذاری شده Base64 با استفاده از ابزار browser.open() به مهاجم منتقل میکند.

Radware گفت: ما یک دستور جدید ایجاد کردیم که بهصراحت به عامل دستور میداد از ابزار browser.open() با URL مخرب استفاده کند. «استراتژی نهایی و موفق ما این بود که به عامل دستور دهیم قبل از افزودن PII استخراجشده به URL، آن را در Base64 کدگذاری کند. ما این اقدام را بهعنوان یک اقدام امنیتی ضروری برای محافظت از دادهها در حین انتقال، طراحی کردیم.»

اثبات ادعا (PoC) به کاربرانی بستگی دارد که ادغام Gmail را فعال میکنند، اما این حمله میتواند به هر کانکتوری[۶] که ChatGPT از آن پشتیبانی میکند، ازجمله Box، Dropbox، GitHub، Google Drive، HubSpot، Microsoft Outlook، Notion یا SharePoint، گسترش یابد و بهطور مؤثر سطح حمله را گسترش دهد.

برخلاف حملاتی مانند [۷]AgentFlayer و EchoLeak[8] که در سمت کلاینت رخ میدهند، استخراج مشاهدهشده در مورد ShadowLeak مستقیماً در محیط ابری OpenAI رخ میدهد، درحالیکه از کنترلهای امنیتی سنتی نیز عبور میکند. این عدم دید، جنبه اصلی است که آن را از سایر آسیبپذیریهای تزریق سریع غیرمستقیم مشابه آن متمایز میکند.

ChatGPT برای حل CAPTCHAها ترغیب شد

این افشاگری در حالی صورت میگیرد که پلتفرم امنیتی هوش مصنوعی SPLX نشان داد که میتوان از پیامهای هوشمندانه، همراه با مسمومیت زمینهای، برای براندازی محافظهای داخلی عامل [۹]ChatGPT و حل CAPTCHAهای مبتنی بر تصویر که برای اثبات انسان بودن کاربر طراحی شدهاند، استفاده کرد.

این حمله اساساً شامل باز کردن یک چت معمولی ChatGPT-4o و متقاعد کردن مدل زبان بزرگ (LLM) برای ارائه طرحی برای حل آنچه بهعنوان لیستی از CAPTCHAهای جعلی برای آن توصیف شده است، میشود. در مرحله بعدی، یک چت عامل ChatGPT جدید باز میشود و مکالمه قبلی با LLM در آن جایگذاری میشود و بیان میشود که این “بحث قبلی ما” بوده است – که عملاً باعث میشود مدل CAPTCHAها را بدون هیچ مقاومتی حل کند.

دوریان شولتز، محقق امنیتی، گفت[۱۰]: “ترفند این بود که CAPTCHA را بهعنوان جعلی تغییر شکل دهیم و مکالمهای ایجاد کنیم که در آن عامل قبلاً موافقت کرده بود که ادامه دهد. با به ارث بردن آن زمینه، دیگر با نشانههای هشداردهندهی معمول مواجه نشد.

این عامل نهتنها CAPTCHA های ساده، بلکه CAPTCHA های مبتنی بر تصویر را نیز حل کرد — حتی مکاننمای خود را برای تقلید از رفتار انسان تنظیم کرد. مهاجمان میتوانند کنترلهای واقعی را بهعنوان «جعلی» تغییر شکل دهند تا از آنها عبور کنند، که این امر بر نیاز به یکپارچگی متن، بهداشت حافظه و همکاری مداوم با تیم قرمز تأکید میکند.

منابع

[۱] https://www.radware.com/blog/threat-intelligence/shadowleak

[۲] https://openai.com/index/introducing-deep-research

[۳] https://blog.google/products/gemini/google-gemini-deep-research

[۴] https://www.perplexity.ai/hub/blog/introducing-perplexity-deep-research

[۵] https://thehackernews.com/2024/12/researchers-uncover-prompt-injection.html

[۶] https://help.openai.com/en/articles/11487775-connectors-in-chatgpt

[۷] https://thehackernews.com/2025/08/researchers-uncover-gpt-5-jailbreak-and.html

[۸] https://thehackernews.com/2025/06/zero-click-ai-vulnerability-exposes.html

[۹] https://openai.com/index/introducing-chatgpt-agent

[۱۰] https://splx.ai/blog/chatgpt-agent-solves-captcha

[۱۱] https://thehackernews.com/2025/09/shadowleak-zero-click-flaw-leaks-gmail.html

ثبت ديدگاه