محققان امنیت سایبری چندین نقص امنیتی را فاش کردهاند که بر ابزارها و چارچوبهای یادگیری ماشین منبع باز (ML) مانند MLflow ،H2O ،PyTorch و MLeap تأثیر میگذارد که میتواند راه را برای اجرای کد هموار کند.

محققان امنیت سایبری چندین نقص امنیتی را فاش کردهاند که بر ابزارها و چارچوبهای یادگیری ماشین منبع باز (ML) مانند MLflow ،H2O ،PyTorch و MLeap تأثیر میگذارد که میتواند راه را برای اجرای کد هموار کند.

این آسیبپذیریها که توسط JFrog کشف شدهاند، بخشی از مجموعه گستردهتر ۲۲ نقص امنیتی است که شرکت امنیت زنجیره تأمین برای اولین بار ماه گذشته افشا کرد[۱].

برخلاف مجموعه اول که شامل نقصهایی در سمت سرور بود، موارد جدید با جزئیات امکان بهرهبرداری از کلاینتهای ML را میدهند و در کتابخانههایی قرار میگیرند که قالبهای مدل ایمن مانند [۲]Safetensors را مدیریت میکنند.

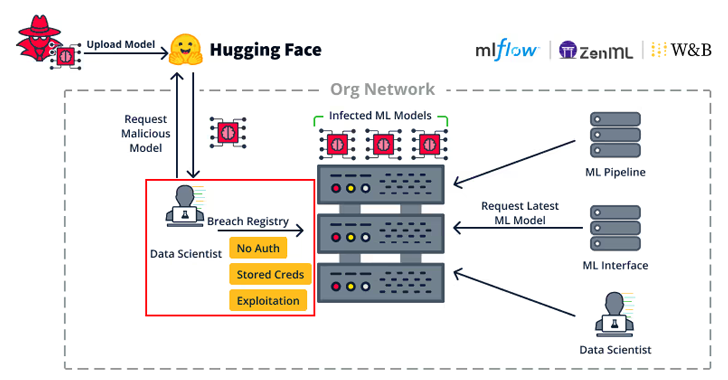

این شرکت گفت[۳]: «ربودن یک کلاینت ML در یک سازمان میتواند به مهاجمان اجازه دهد تا حرکات جانبی گستردهای را در داخل سازمان انجام دهند. یک کلاینت ML بهاحتمالزیاد به خدمات مهم ML مانند ML Model Registries یا MLOps Pipelines دسترسی دارد.»

این بهنوبه خود میتواند اطلاعات حساسی مانند اعتبارنامههای رجیستری مدل را فاش کند و عملاً به یک عامل مخرب اجازه دهد تا مدلهای ML ذخیرهشده در پشتی را پشت سر بگذارد یا به اجرای کد دست یابد.

لیست آسیبپذیریها در زیر آمده است:

- CVE-2024-27132 (امتیاز ۷٫۲ در CVSS) – یک مشکل sanitization ناکافی در MLflow که منجر به حمله اسکریپت بین سایتی (XSS) در هنگام اجرای دستورالعمل[۴] غیرقابلاعتماد در یک نوت بوک Jupyter میشود و درنهایت منجر به اجرای کد از راه دور سمت سرویسگیرنده میشود ( RCE)

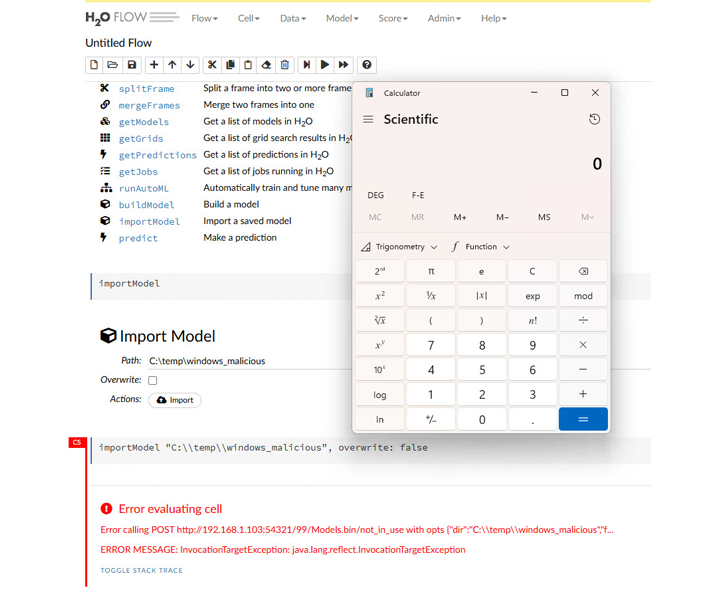

- CVE-2024-6960 (امتیاز ۷٫۵ در CVSS) – یک مشکل غیر ایمنسازی در H20 هنگام وارد کردن یک مدل ML غیرقابلاعتماد، که بهطور بالقوه منجر به RCE میشود.

- یک مشکل پیمایش مسیر در ویژگی TorchScript PyTorch که میتواند منجر به انکار سرویس (DoS) یا اجرای کد به دلیل بازنویسی دلخواه فایل شود، که میتواند برای بازنویسی فایلهای مهم سیستم یا یک فایل pickle قانونی (بدون شناسه CVE) استفاده شود.

- CVE-2023-5245 (امتیاز ۷٫۵ در CVSS) – یک مشکل پیمایش مسیر در MLeap هنگام بارگیری یک مدل ذخیرهشده در قالب فشرده میتواند منجر به آسیبپذیری [۵]Zip Slip شود که منجر به بازنویسی دلخواه پرونده و اجرای کد بالقوه میشود.

JFrog خاطرنشان کرد که مدلهای ML نباید کورکورانه بارگذاری شوند، حتی در مواردی که از یک نوع امن، مانند Safetensors بارگذاری میشوند، زیرا آنها توانایی اجرای کد دلخواه را دارند.

Shachar Menashe، معاون تحقیقات امنیتی JFrog در بیانیهای گفت: ابزارهای هوش مصنوعی و یادگیری ماشین (ML) پتانسیل بسیار زیادی برای نوآوری دارند، اما همچنین میتوانند در را برای مهاجمان باز کنند تا آسیب گستردهای به هر سازمانی وارد کنند.

“برای محافظت در برابر این تهدیدات، مهم است که بدانید از کدام مدلها استفاده میکنید و هرگز مدلهای غیرقابلاعتماد ML را حتی از یک مخزن ML “ایمن” بارگیری نکنید. انجام این کار میتواند منجر به اجرای کد از راه دور در برخی سناریوها شود و آسیبهای زیادی به سازمان شما وارد کند.”

منابع

[۱] https://thehackernews.com/2024/11/security-flaws-in-popular-ml-toolkits.html

[۲] https://thehackernews.com/2024/02/new-hugging-face-vulnerability-exposes.html

[۳] https://jfrog.com/blog/machine-learning-bug-bonanza-exploiting-ml-clients-and-safe-models/

[۴] https://mlflow.org/docs/latest/recipes.html

[۵] https://thehackernews.com/2023/10/openrefines-zip-slip-vulnerability.html

[۶] https://thehackernews.com/2024/12/researchers-uncover-flaws-in-popular.html

ثبت ديدگاه