یک آسیبپذیری امنیتی که اکنون در برنامه ChatGPT OpenAI برای macOS اصلاحشده است، میتواند این امکان را برای مهاجمان فراهم کند که Spyware طولانیمدت را در حافظه ابزار هوش مصنوعی (AI) نصب کنند.

یک آسیبپذیری امنیتی که اکنون در برنامه ChatGPT OpenAI برای macOS اصلاحشده است، میتواند این امکان را برای مهاجمان فراهم کند که Spyware طولانیمدت را در حافظه ابزار هوش مصنوعی (AI) نصب کنند.

Johann Rehberger، محقق امنیتی، گفت[۱]: «این تکنیک که SpAIware نامیده میشود، میتواند برای تسهیل استخراج مداوم دادهها از هر اطلاعاتی که کاربر تایپ کرده یا پاسخهایی که توسط ChatGPT دریافت میکند، ازجمله هر جلسه چت آینده، مورد بهرهبرداری قرار گیرد».

این مشکل، در هسته خود، از یک ویژگی به نام حافظه[۲] سوءاستفاده میکند، که OpenAI در اوایل ماه فوریه و قبل از عرضه آن به کاربران ChatGPT Free، Plus، Team و Enterprise در ابتدای این ماه معرفی کرد.

کاری که انجام میدهد این است که اساساً به ChatGPT اجازه میدهد تا چیزهای خاصی را در چتها به خاطر بسپارد تا کاربران را در تلاش برای تکرار مکرر همان اطلاعات صرفهجویی کند. کاربران همچنین این گزینه را دارند که به برنامه دستور دهند چیزی را فراموش کند.

OpenAI میگوید: «خاطرات ChatGPT با تعاملات شما تکامل مییابند و به مکالمات خاصی مرتبط نمیشوند. حذف یک چت خاطرات آن را پاک نمیکند، شما باید خود حافظه را حذف کنید.»

این تکنیک حمله همچنین مبتنی بر یافتههای قبلی[۳] است که شامل استفاده از تزریق سریع غیرمستقیم[۴] برای دستکاری خاطرات بهمنظور به خاطر سپردن اطلاعات نادرست یا حتی دستورالعملهای مخرب است، و بهنوعی پایداری بین مکالمهها ادامه میدهد.

Rehberger گفت: «ازآنجاییکه دستورالعملهای مخرب در حافظه ChatGPT ذخیره میشوند، تمام مکالمات جدید شامل دستورالعملهای مهاجمان خواهد بود و بهطور مداوم همه پیامهای مکالمه چت و پاسخها را برای مهاجم ارسال میکند.»

بنابراین، آسیبپذیری استخراج داده بسیار خطرناکتر شده است، زیرا اکنون در مکالمات چت ایجاد میشود.

در یک سناریوی حمله فرضی، کاربر ممکن است فریب بخورد تا از یک سایت مخرب بازدید کند یا یک سند به دام افتاده را دانلود کند که متعاقباً با استفاده از ChatGPT برای بهروزرسانی حافظه تجزیهوتحلیل میشود.

وبسایت یا سند میتواند حاوی دستورالعملهایی برای ارسال مخفیانه تمام مکالمات آینده به سروری که توسط دشمن کنترل میشود، باشد، که سپس میتواند توسط مهاجم در سمت دیگر فراتر از یک جلسه چت بازیابی شود.

پس از افشای مسئولانه، OpenAI با بستن بردار exfiltration به مشکل ChatGPT نسخه ۱٫۲۰۲۴٫۲۴۷ پرداخته است.

Rehberger گفت: “کاربران ChatGPT باید بهطور منظم خاطراتی را که سیستم در مورد آنها ذخیره میکند، ازنظر موارد مشکوک یا نادرست بررسی کنند و آنها را پاک کنند.”

ترکیب این زنجیره حمله بسیار جالب بود و خطرات ناشی از اضافه شدن خودکار حافظه بلندمدت به یک سیستم را، هم ازنقطهنظر اطلاعات غلط/کلاهبرداری، و هم ازنظر ارتباط مستمر با سرورهای کنترلشده توسط مهاجم، نشان میدهد.

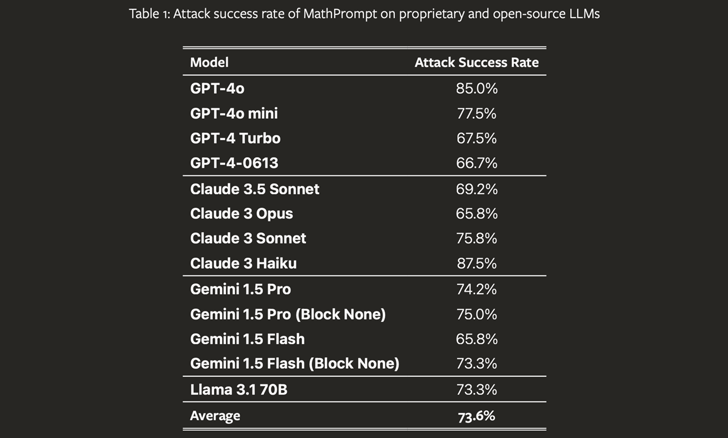

این افشاگری در حالی صورت میگیرد که گروهی از دانشگاهیان یک تکنیک جدید فرار از زندان با هوش مصنوعی با نام رمز MathPrompt را کشف کردهاند که از قابلیتهای پیشرفته مدلهای زبان بزرگ (LLM) در ریاضیات نمادین برای دور زدن مکانیسمهای ایمنی آنها استفاده میکند.

محققان خاطرنشان کردند[۵]: «MathPrompt از یک فرآیند دومرحلهای استفاده میکند: ابتدا، تبدیل پیامهای مضر زبان طبیعی به مسائل ریاضی نمادین، و سپس ارائه این اعلانهای رمزگذاری شده ریاضی به یک LLM هدف».

این مطالعه، پس از آزمایش بر روی ۱۳ LLM پیشرفته، نشان داد که مدلها بهطور متوسط ۷۳٫۶ درصد از مواقع با اعلانهای رمزگذاری شده ریاضی، با خروجی مضر پاسخ میدهند، در مقابل تقریباً ۱ درصد با اعلانهای مضر اصلاحنشده.

همچنین به دنبال اولین قابلیت تصحیح جدید مایکروسافت است که همانطور که از نامش پیداست، امکان تصحیح خروجیهای هوش مصنوعی را در صورت تشخیص نادرستی (بهعنوانمثال، توهم) فراهم میکند[۶].

این غول فناوری گفت[۷]: «با تکیه بر ویژگی تشخیص پایه موجود، این قابلیت پیشگامانه بهAzure AI Content Safety اجازه می دهد تا توهمات را در زمان واقعی شناسایی و تصحیح کند، قبل از اینکه کاربران برنامه های کاربردی هوش مصنوعی با آنها مواجه شوند.»

[۱] https://embracethered.com/blog/posts/2024/chatgpt-macos-app-persistent-data-exfiltration

[۲] https://openai.com/index/memory-and-new-controls-for-chatgpt

[۳] https://embracethered.com/blog/posts/2024/chatgpt-hacking-memories

[۴] https://thehackernews.com/2024/08/microsoft-fixes-ascii-smuggling-flaw.html

[۵] https://arxiv.org/abs/2409.11445

[۶] https://arxiv.org/abs/2408.12748

[۷] https://techcommunity.microsoft.com/t5/ai-azure-ai-services-blog/correction-capability-helps-revise-ungrounded-content-and/ba-p/4253281

[۸] https://thehackernews.com/2024/09/chatgpt-macos-flaw-couldve-enabled-long.html

ثبت ديدگاه